Hive 单点部署

需要提前部署 hadoop 并启动

需要提前部署 MySQL 并启动

1、解压Hive

cd /opt/software

tar -zxvf apache-hive-3.1.2-bin.tar.gz

mv apache-hive-3.1.2-bin /opt/module/hive-3.1.2

2、profile 配置

vim /etc/profile

#HIVE

export HIVE_HOME=/opt/module/hive-3.1.2

export PATH=$PATH:$HIVE_HOME/bin

# 分发

scp -r /etc/profile slave1:/etc/

scp -r /etc/profile slave2:/etc/

source /etc/profile

3、拷贝驱动

cp /opt/software/mysql-connector-java-5.1.37.jar $HIVE_HOME/lib/

4、解决冲突

# guava冲突

rm -rf $HIVE_HOME/lib/guava-19.0.jar

cp $HADOOP_HOME/share/hadoop/common/lib/guava-27.0-jre.jar $HIVE_HOME/lib/

# 日志jar包冲突

mv $HIVE_HOME/lib/log4j-slf4j-impl-2.10.0.jar $HIVE_HOME/lib/log4j-slf4j-impl-2.10.0.bak

5、Hive-env

mv $HIVE_HOME/conf/hive-env.sh.template $HIVE_HOME/conf/hive-env.sh

vim $HIVE_HOME/conf/hive-env.sh

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export HIVE_CONF_DIR=/opt/module/hive-3.1.2/conf

6、hive-site

vim $HIVE_HOME/conf/hive-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- jdbc 连接的 URL -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://master:3306/metastore?useSSL=false</value>

</property>

<!-- jdbc 连接的 Driver-->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- jdbc 连接的 username-->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- jdbc 连接的 password -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>000000</value>

</property>

<!-- Hive 元数据存储版本的验证 -->

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<!--元数据存储授权-->

<property>

<name>hive.metastore.event.db.notification.api.auth</name>

<value>false</value>

</property>

<!-- Hive 默认在 HDFS 的工作目录 -->

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<!-- 查询结果是否显示字段名 -->

<property>

<name>hive.cli.print.header</name>

<value>true</value>

</property>

<!-- 是否显示当前所处数据库 -->

<property>

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

</configuration>

7、创建Hive元数据库

mysql -u root -p

create database metastore;

quit;

8、HDFS创建目录

hadoop fs -mkdir /tmp

hadoop fs -mkdir -p /user/hive/warehouse

hadoop fs -chmod g+w /tmp

hadoop fs -chmod g+w /user/hive/warehouse

9、初始化Hive元数据库

$HIVE_HOME/bin/schematool -initSchema -dbType mysql -verbose

10、关闭启动日志

vim $HIVE_HOME/conf/log4j.properties

log4j.rootLogger=WARN,CA

log4j.appender.CA=org.apache.log4j.ConsoleAppender

log4j.appender.CA.layout=org.apache.log4j.PatternLayout

log4j.appender.CA.layout.ConversionPattern=%-4r [%t] %-5p %c %x - %m%n

11、Hive CLI启动

# 启动

hive

hive -hiveconf hive.exec.mode.local.auto=true;

# 退出

quit;

exit;

12、解决插入数据报错

set hive.exec.mode.local.auto=true;

13、测试

show databases;

show tables;

create table stu(id int, name string);

insert into stu values(1, "ss");

select * from stu;

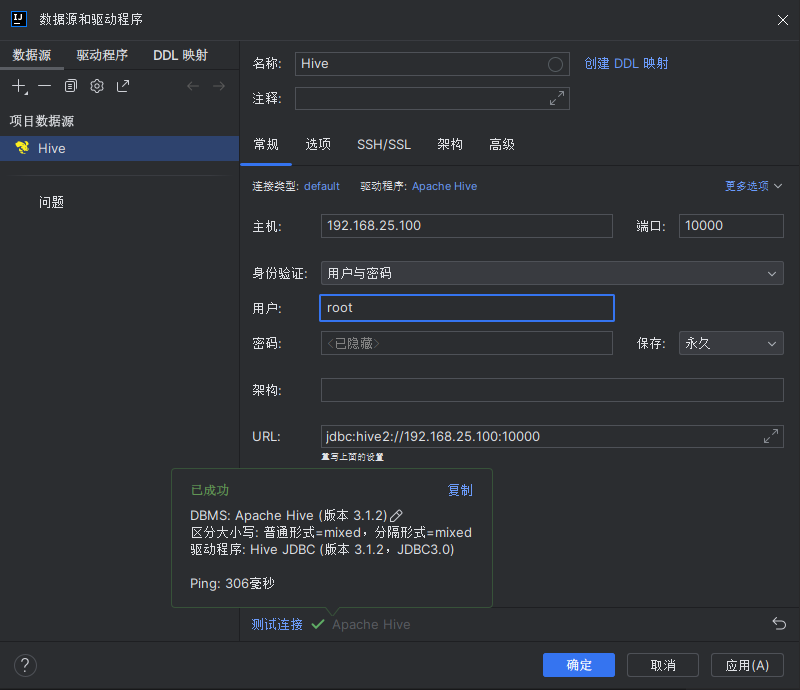

14、配置hiveserver2

vim $HADOOP_HOME/etc/hadoop/core-site.xml

<!-- 配置所有节点的root用户都可作为代理用户 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<!-- 配置root用户能够代理的用户组为任意组 -->

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<!-- 配置root用户能到代理的用户为任意用户 -->

<property>

<name>hadoop.proxyuser.root.users</name>

<value>*</value>

</property>

# 分发

scp $HADOOP_HOME/etc/hadoop/core-site.xml slave1:$HADOOP_HOME/etc/hadoop/

scp $HADOOP_HOME/etc/hadoop/core-site.xml slave2:$HADOOP_HOME/etc/hadoop/

# 重启HDFS、Yarn

vim $HIVE_HOME/conf/hive-site.xml

<!-- 指定hiveserver2连接的host -->

<property>

<name>hive.server2.thrift.bind.host</name>

<value>master</value>

</property>

<!-- 指定hiveserver2连接的端口号 -->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

15、启动hiveserver2

# 方式1

nohup $HIVE_HOME/bin/hiveserver2 >/dev/null 2>&1 &

# 方式2

screen -R hive

$HIVE_HOME/bin/hiveserver2

16、beeline远程

# 使用命令行客户端beeline进行远程访问

$HIVE_HOME/bin/beeline

# 连接

!connect jdbc:hive2://master:10000

# 提示输入用户名:root

Enter username for jdbc:hive2://master:10000:

# 提示输入密码:不填直接回车

Enter password for jdbc:hive2://master:10000:

# 退出

!quit

17、IDEA远程

许可协议:

CC BY 4.0